AIの進化とデータプライバシーの課題

要約

AIの進化により、個人データの効率的な活用が可能になる一方で、データプライバシーの課題が顕在化しています。GDPRなどの規制に対応しつつ、プライバシーバイデザインと倫理的AIの実践が求められますが、多くの組織では、プライバシーに関する予算削減やスキルギャップが大きな障壁となっています。

詳細分析

主なポイント

- 欧州のプライバシー専門家の40%以上が、自社のデータプライバシー対策への投資が不十分だと考えている

- 54%の専門家が2025年にプライバシー予算が減少すると予想している

- GDPR施行後も、38%の専門家しか自社のデータ保護能力に自信を持っていない

- 欧州企業の24%しかプライバシーバイデザインの原則を遵守していない

- プライバシー専門家の66%が、5年前と比べて業務がより ストレスフルになっていると回答

社会的影響

- 企業のデータ保護能力の低さは、顧客や従業員の個人情報の漏洩リスクを高める

- プライバシー対策の不備は、GDPR違反などの法的リスクにもつながる

- プライバシー専門家の業務ストレスの高まりは、人材流出や組織の脆弱性につながる可能性がある

編集長の意見

AIの進化により、プライバシーに対する課題が取り沙汰されているのですから、企業はプライバシーバイデザインの原則を徹底的に実践し、プライバシー専門家を適切に配置・育成する必要があると思います。そうすることで、長期的な視点でデータ保護を実現し、ステークホルダーの信頼を醸成できるでしょう。しかし、世の中の企業のの流れは、逆行し、予算削減というのが主流になっているようです。プライバシー関連の予算削減の圧力に直面する中、プライバシー対策への投資を維持することが重要な課題だと認識してください。

本日は、プライバシーを保護するための「倫理的AI」について。を解説します。

解説

AIの進化とデータプライバシーの課題

AIが絡むことで今まで安全だと思われていたエンドツーエンド暗号化の安全性、プライバシーが侵害されつつある。というお話から、 人の倫理がサイバーセキュリティに大きく関わっているお話しをしました。

Apple Intelligence、Googleの詐欺電話防止機能でプライバシーはどうなる?AIとエンドツーエンド暗号化(E2EE)の関係について

米軍兵士がAT&TとVerizonのハッキングに関与していたことを司法省が確認

では、AIに倫理はあるのか?ということを考えてみたくなり、この記事をピックアップしました。

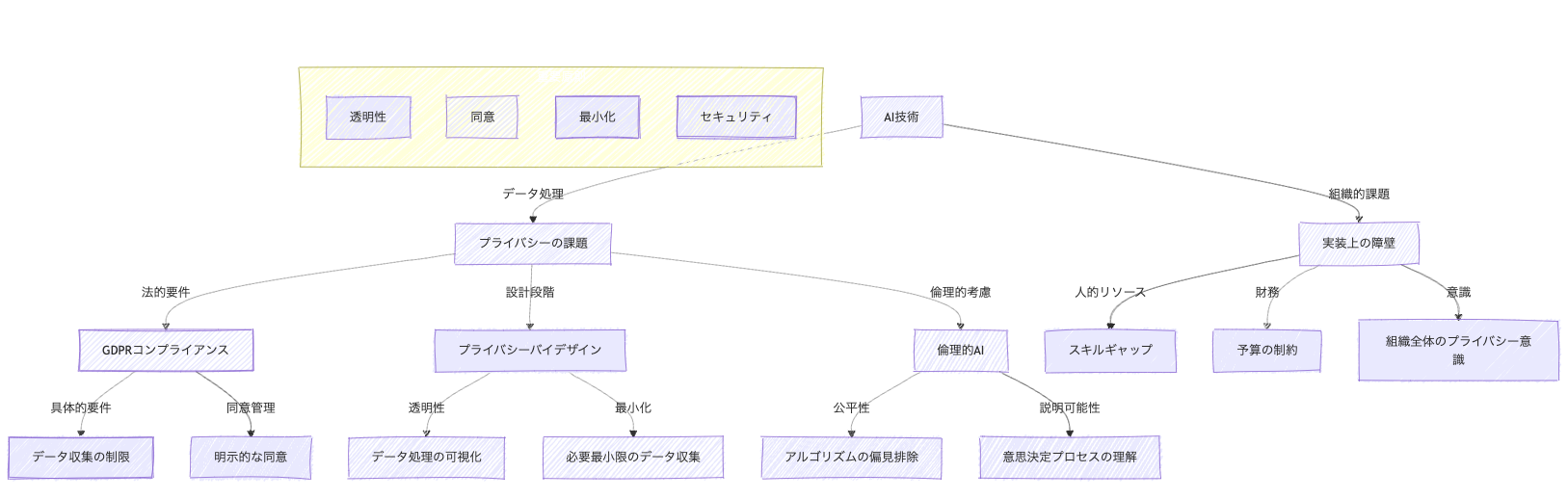

AI技術がどのように人間のプライバシーに関わっているのかを絵でまとめてみました。

AIは、その驚異的な能力で社会を大きく変革し、私たちの生活のあらゆる側面に浸透しつつあります。

しかし、この技術がもたらす恩恵と同時に、データプライバシーや倫理に関する懸念も高まっています。

特に、AIが大量の個人データを処理し、自動的な意思決定を行う場面では、個人の権利と自由が脅かされるリスクが存在します。

AIシステムは、医療診断、金融審査、採用選考など、私たちの生活に大きな影響を与える重要な決定に関わるようになってきました。

しかし、これらのAIシステムが、偏ったデータで学習したり、アルゴリズム自体に潜在的な偏見を持っている場合、不公平な結果を生み出す可能性があります。

例えば、過去のデータに基づいて採用選考を行うAIは、特定の性別や人種に不利な判断を永続化させる危険性があります。

このような状況を踏まえ、AIの倫理的な利用が不可欠な課題となっています。

倫理的AIとは、AIシステムの設計、開発、運用において、個人のプライバシー、公平性、透明性を尊重し、人間の尊厳を守ることを目指す概念です。

具体的には、AIシステムがどのように意思決定を行うかを理解可能にし、偏見のないデータで学習させ、個人情報の保護を徹底することが求められます。

組織がAIを導入する際には、単に技術的な効率性だけでなく、倫理的な側面を考慮する必要があります。

そのためには、プライバシーを考慮した設計(privacy by design)を初期段階から組み込み、データ収集を必要最小限に制限し、ユーザーの明確な同意を得ることが重要になります。 また、AIの意思決定プロセスを透明化し、説明責任を果たすことも、信頼を構築する上で欠かせません。

さらに、組織は、AIの倫理的な利用を促進するための規制やガイドラインを遵守する必要があります。

例えば、欧州連合(EU)の一般データ保護規則(GDPR)やEU AI法は、AIシステムが個人の権利を尊重し、公平性と透明性を確保することを義務付けています。

これらの規制を遵守するとともに、組織全体で倫理的なAI利用を促進する文化を醸成することが重要となります。

本稿では、AI倫理の重要性と、その実現に向けた課題と対策について詳しく解説します。

AI技術の進歩に伴い、倫理的な側面を軽視することは、社会全体に深刻な影響を及ぼしかねません。

そのため、倫理的なAIの利用は、技術者、企業リーダー、政策立案者、そして社会全体で取り組むべき重要な課題なのです。

AI統合とデータプライバシー

AIは、大量の個人データを利用して、個人の購買行動や健康状態を正確に予測するなどの高度な意思決定を可能にします。しかし、これらの予測の精度は、個人情報保護に関する重大な懸念を引き起こします。特に、AIが自動的に意思決定を行う場合、その影響は大きく、例えば、ローンの審査、採用選考、保険金請求の承認など、個人の経済状況、雇用機会、健康状態、オンラインプレゼンスに直接的な影響を与える可能性があります。

GDPRコンプライアンスの課題

AIシステムを開発・運用する組織は、GDPRなどのデータ保護規制を遵守する必要があります。GDPRでは、個人データの処理は、法的な根拠がある場合、契約に必要な場合、またはデータ主体の明示的な同意がある場合にのみ許可されています。特にAIシステムが、個人の生活に大きな影響を与える意思決定を行う場合、その処理の正当性と透明性を確保することが求められます。

例えば、顔認識技術は、犯罪防止、アクセス管理、ソーシャルメディアでの友達のタグ付けなど、さまざまな目的に使用できますが、それぞれの用途に応じて異なる法的根拠が必要となり、異なるリスクを伴います。また、AIシステムの開発段階と展開段階では、リスクの種類が異なるため、組織はそれぞれの段階で適切な対策を講じる必要があります。

プライバシー保護対策

AIシステムにおけるプライバシー保護は、設計段階から組み込まれるべきです(プライバシーバイデザイン)。このアプローチでは、データ収集を必要最小限に抑え、データ処理活動の透明性を確保し、ユーザーの明示的な同意を得ることが重要になります。また、データの暗号化、アクセス制御、定期的な脆弱性評価も、データプライバシーを保護するための重要な要素です。

AIの倫理的な利用

AIを倫理的に利用することは、責任あるAIの利用の基礎となります。AIアルゴリズムの透明性と公平性は、偏見を避け、倫理的なデータ利用を確保するために不可欠です。そのためには、多様で代表的な学習データを使用し、アルゴリズムを定期的に評価・調整する必要があります。また、AIアルゴリズムは、理解可能で説明可能なものでなければならず、ユーザーと利害関係者の間で信頼を築く必要があります。

規制の動向

AIに関する規制環境は常に変化しており、AIがもたらす固有の課題に対処するための新しい法律やガイドラインが登場しています。EUでは、GDPRがデータ保護の基本であり、データ最小化、透明性、プライバシーバイデザインを重視しています。また、EU AI法は、AIシステムの潜在的なリスクと影響に基づいて義務を定め、基本的人権、民主主義、法の支配を尊重することを求めています。世界中の他の地域でも、同様に厳格なデータ保護要件が導入されています。例えば、カリフォルニア州消費者プライバシー法(CCPA)は、消費者に個人情報に関する特定の権利を付与し、米国の医療業界では、医療保険の相互運用性と説明責任に関する法律(HIPAA)がAIシステムによって処理される医療情報のデータプライバシーとセキュリティに関する規定を定めています。

組織における課題と対策

多くの組織がAIの倫理的な利用を重要視していますが、具体的な取り組みには多くの課題が存在します。

- 予算不足と人員不足: 多くの組織は、データプライバシーとAI倫理のイニシアチブに十分な予算と人員を割り当てることができていません。特にプライバシー専門家の採用が難しく、スキルギャップを埋めることが課題となっています。

- スキルギャップ: 技術的な専門知識、IT運用スキル、および新しいAI技術に関する知識を持つ人材が不足しています。特に、プライバシーバイデザインの実践に必要なスキルを持つ人材が不足していることが問題です。

- ストレス: プライバシー専門家の仕事は、複雑化する脅威の状況と規制の変更により、ますますストレスフルになっています。このような状況が、人員の定着率低下につながる可能性もあります。

これらの課題に対処するために、組織は以下のような対策を講じる必要があると考えます。

- プライバシーバイデザインの採用: AIシステムの初期段階からプライバシー保護を組み込むことで、データ漏洩のリスクを減らし、規制遵守を容易にすることができます。

- トレーニングと教育: 従業員、特にプライバシーに関わらない従業員に対して、データプライバシーとAI倫理に関するトレーニングを提供することで、組織全体の意識を高めることができます。

- 技術的ソリューション: 暗号化、アクセス制御、データ匿名化などの技術を活用して、データプライバシーを保護します。

- 専門家の育成とサポート: プライバシー専門家に対して、継続的なトレーニングとサポートを提供し、組織のレジリエンスを維持します。

データプライバシーへの信頼と組織の責任

AIの導入を進めるにあたり、データプライバシーの保護は、単なる法的な義務ではなく、組織の信頼を維持するために不可欠な要素です。組織がユーザーのプライバシーを尊重し、データの取り扱いに関する透明性を確保することで、信頼を構築し、長期的な関係を築くことができます。

また、倫理的なAIの利用は、組織の社会的責任を果たす上で重要な要素です。AI技術を倫理的に利用することで、社会的な不公平を解消し、より公正で包容的な社会を実現することに貢献できます。

まとめ

AI技術の急速な進歩は、私たちの生活を大きく変え、さまざまな分野で効率性と利便性をもたらしています。しかし、その一方で、AIの利用に伴うデータプライバシーと倫理的な問題への懸念も高まっています。特に、AIシステムが大量の個人データを処理し、自動的に意思決定を行う場面では、個人の権利と自由が脅かされるリスクがあります。

AI倫理とは、AIシステムの設計、開発、運用において、個人のプライバシー、公平性、透明性を尊重し、人間の尊厳を守ることを目指す概念です。組織がAIを導入する際には、単に技術的な効率性だけでなく、倫理的な側面を考慮する必要があります。そのためには、プライバシーバイデザインを初期段階から組み込み、データ収集を必要最小限に制限し、ユーザーの明確な同意を得ることが重要になります。

また、AIの意思決定プロセスを透明化し、説明責任を果たすことも、信頼を構築する上で欠かせません。AIアルゴリズムが偏見のないデータで学習し、公平な判断を下すように努めなければなりません。また、組織は、AIの倫理的な利用を促進するための規制やガイドラインを遵守する必要があります。

倫理的AIの実現には、組織が抱えるさまざまな課題に対処する必要があります。予算不足、人員不足、スキルギャップ、従業員のストレスなどの問題は、AIの倫理的な利用を阻害する可能性があります。組織は、プライバシーバイデザインの採用、トレーニングと教育の提供、技術的なソリューションの活用、専門家の育成とサポートなど、包括的な対策を講じる必要があります。

データプライバシーの保護は、組織の信頼を維持するために不可欠な要素です。組織がユーザーのプライバシーを尊重し、データの取り扱いに関する透明性を確保することで、信頼を構築し、長期的な関係を築くことができます。また、倫理的なAIの利用は、組織の社会的責任を果たす上で重要な要素です。

AI技術を倫理的に利用することで、社会的な不公平を解消し、より公正で包容的な社会を実現することに貢献できるのではないでしょうか?

「AIの驚くべき可能性を追求しながら、同時に人間の尊厳、プライバシー、公平性を守ること。」 これが、私たちが取り組むべき最も重要な課題です。 倫理的AIは、単なる技術的な挑戦ではなく、私たちの価値観と社会の未来を形作る重要な責任だと思うのです。 継続的な教育、厳格な倫理ガイドライン、そして人間中心のアプローチが、倫理的なAIの実現に向けて不可欠なのではないでしょうか?

本稿が、AIの倫理的な利用に関する理解を深める上で、少しでもお役に立てば幸いです。

背景情報

- GDPR(EU一般データ保護規則)は2018年5月に施行されたが、依然として多くの企業がプライバシー対策に課題を抱えている

- AI法やデジタルサービス法など、新しいEU規制の施行も控えている

- プライバシー分野は脅威の複雑化により、より難しい環境になっている